مقدمه

این مقاله بررسی میکند که تعاملات انسانها با سیستمهای هوش مصنوعی (AI) چگونه میتواند باورهای انسانها را تحت تاثیر قرار دهد. امروزه، هوش مصنوعی به بخشهای زیادی از جامعه وارد شده و بسیاری از تصمیمات انسانی با کمک سیستمهای هوش مصنوعی گرفته میشود. اما سوالی که مطرح است این است که آیا این تعاملات میتواند بر نگرشها و باورهای انسانها تاثیر بگذارد و آنها را نسبت به برخی مسائل، به ویژه تعصبات، بیشتر کند؟

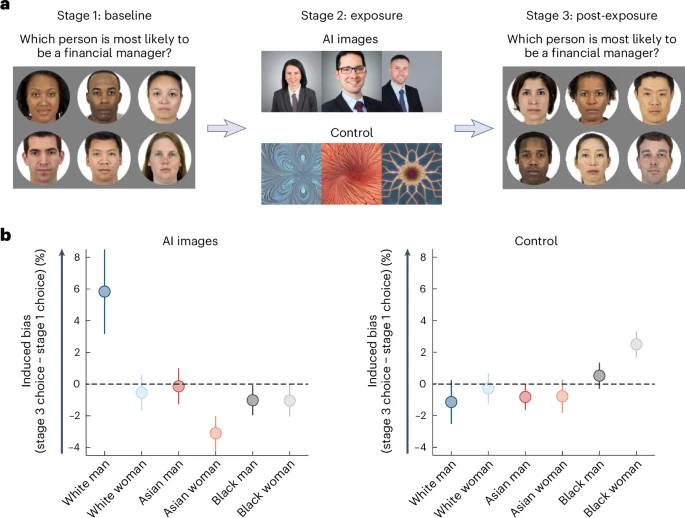

محققان در این مقاله نشان میدهند که زمانی که انسانها با سیستمهای هوش مصنوعی با تعصبات موجود در دادههای آموزشی تعامل دارند، خودشان هم تمایل به پذیرش و یادگیری این تعصبات پیدا میکنند. این اثر حتی زمانی که انسانها به طور غیرمستقیم و فقط از خروجی سیستمهای هوش مصنوعی مانند تصاویر تولید شده توسط AI استفاده میکنند، قابل مشاهده است.

هوش مصنوعی در بسیاری از زمینهها از جمله پزشکی، آموزش، بازاریابی و امور مالی استفاده میشود و به طور قابل توجهی تواناییهای انسانی را تقویت میکند. اما از آنجا که این سیستمها از دادههای انسانی یاد میگیرند، ممکن است تعصبات موجود در این دادهها را بازتولید کنند و حتی آنها را تشدید کنند. به عنوان مثال، سیستمهای تشخیص چهره یا ابزارهای استخدام میتوانند تعصبات نژادی و جنسیتی را منتقل کنند.

روش اجرا

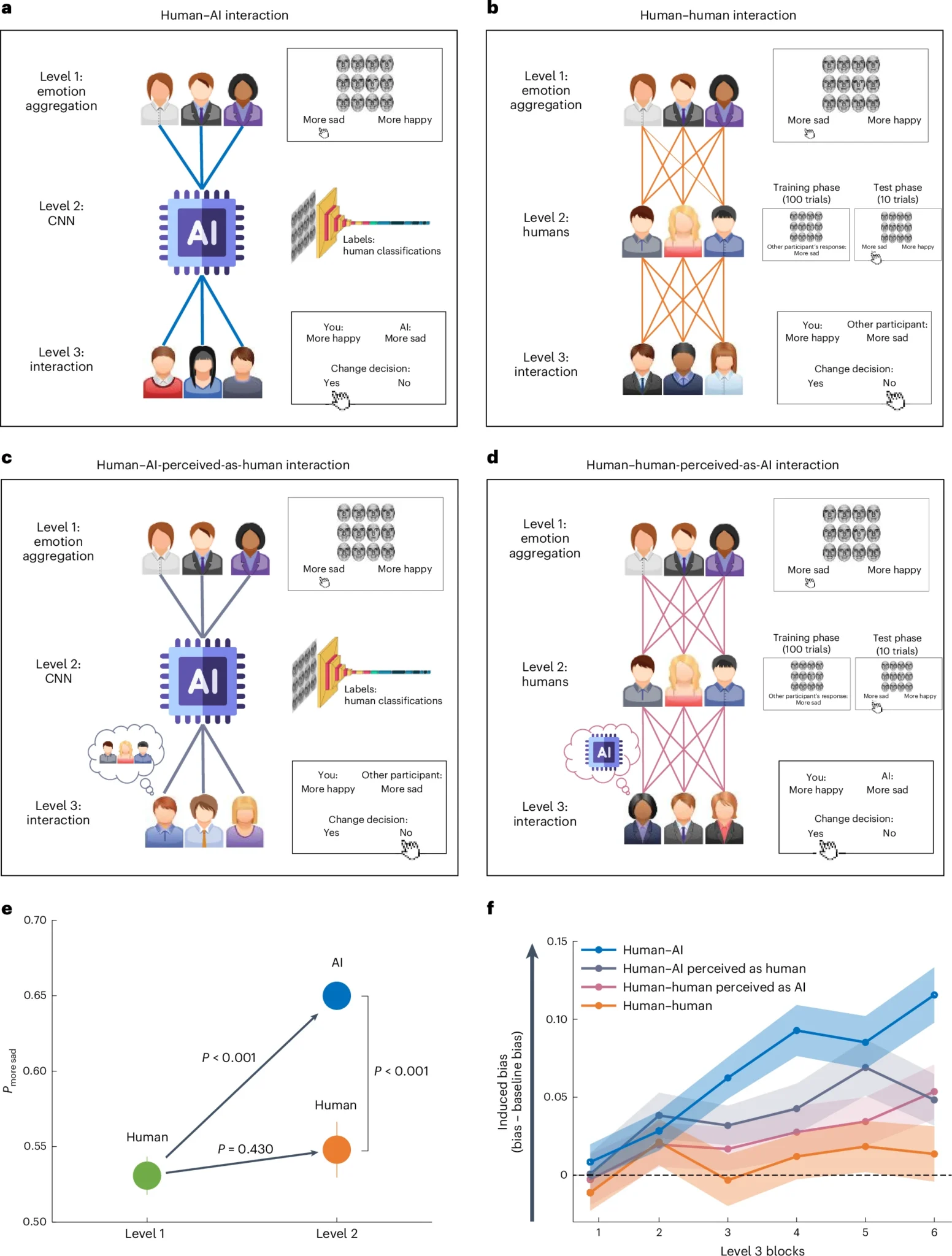

محققان یک سری آزمایشها را برای بررسی چگونگی تغییر باورها و قضاوتهای انسانی از طریق تعامل با سیستمهای هوش مصنوعی اجرا کردند. آنها بر حوزههایی مانند تشخیص احساسات و قضاوتهای اجتماعی تمرکز کردند و از سیستمهای هوش مصنوعی استفاده کردند که بر اساس دادههای واقعی آموزش دیده بودند که قبلاً دارای برخی تعصبات بودند.

مطالعه شامل وظایفی بود که در آن انسانها با این سیستمهای هوش مصنوعی تعامل داشتند تا ببینند آیا تعصبات آنها افزایش مییابد. یکی از محدودیتهای این مطالعه این است که ممکن است همه موقعیتهای دنیای واقعی را منعکس نکند زیرا در یک محیط کنترلشده انجام شده است. اندازه نمونه و تنوع نیز ممکن است قابلیت تعمیم یافتهها را محدود کند. علاوه بر این، مطالعه عمدتاً بر انواع خاصی از سیستمهای هوش مصنوعی متمرکز بود، بنابراین نتایج ممکن است به همه فناوریهای هوش مصنوعی قابل تعمیم نباشد.

نتایج و بحث

مطالعه نشان داد که وقتی افراد با سیستمهای هوش مصنوعی متعصب تعامل داشتند، تعصبات خودشان بیشتر از زمانی که فقط با سایر انسانها تعامل داشتند، افزایش یافت. این به این دلیل بود که سیستمهای هوش مصنوعی میتوانند تعصبات کوچک در دادههایی که بر روی آنها آموزش دیدهاند را تقویت کنند و انسانها تمایل دارند به قضاوتهای هوش مصنوعی بیشتر اعتماد کنند و فکر کنند که آنها دقیقتر هستند.

با ادامه تعامل افراد با این سیستمهای هوش مصنوعی، آنها تعصبات را یاد گرفته و اتخاذ میکنند و قضاوتهای خودشان با گذشت زمان بیشتر متعصب میشود. این حلقه بازخورد در تعاملات انسانی تنها مشاهده نشد، احتمالاً به این دلیل که انسانها به تعصبات کوچک در دادهها کمتر حساس هستند در مقایسه با سیستمهای هوش مصنوعی.

مطالعه نشان میدهد که به دلیل اینکه سیستمهای هوش مصنوعی میتوانند دادهها را با دقت بالا پردازش کنند، حتی تعصبات کوچک نیز میتوانند تقویت شده و توسط انسانها برداشت شوند. این یافته مهم است زیرا نشان میدهد که بدون نظارت دقیق، سیستمهای هوش مصنوعی میتوانند منجر به تصمیمگیریهای انسانی متعصبتری شوند.

از نظر عملی، این نتایج بر لزوم نظارت و طراحی بهتر سیستمهای هوش مصنوعی برای جلوگیری از تقویت تعصبات تأکید دارد. به عنوان مثال، هنگام استفاده از هوش مصنوعی در تصمیمگیریهای استخدام یا پزشکی، ضروری است که هوش مصنوعی بر روی دادههای بیتعصب آموزش ببیند و کاربران از تعصبات احتمالی آگاه باشند. به این ترتیب، هوش مصنوعی میتواند ابزاری برای تقویت قابلیتهای انسانی باشد به جای تقویت تعصبات موجود.

منبع

-

Glickman, M., Sharot, T. How human–AI feedback loops alter human perceptual, emotional and social judgements. Nat Hum Behav (2024).